Nous vivons aujourd’hui dans un monde où nos moindres comportements numériques laissent des traces exploitables. Avons-nous vraiment mesuré les conséquences de cette réalité sur notre autonomie décisionnelle et sur nos démocraties ?

En mars 2018, un scandale d’une ampleur sans précédent éclatait, révélant au grand public l’existence d’un système sophistiqué de manipulation de l’opinion via les réseaux sociaux. Cambridge Analytica, une entreprise britannique de conseil en stratégie, était accusée d’avoir exploité les données personnelles de plus de 87 millions d’utilisateurs Facebook, à leur insu, pour influencer des scrutins majeurs comme l’élection présidentielle américaine de 2016 et le référendum sur le Brexit.

Cette affaire a brusquement mis en lumière les dangers du big data et de la psychologie comportementale lorsqu’ils sont utilisés à des fins de manipulation politique massive. En tant que psychologue spécialisé en ciberpsychologie, j’observe depuis longtemps avec inquiétude l’évolution de ces techniques d’influence. L’affaire Cambridge Analytica n’est pas un incident isolé, mais plutôt la partie émergée d’un iceberg qui menace les fondements mêmes de notre contrat social et de nos démocraties.

Dans cet article, nous explorerons ensemble les mécanismes psychologiques exploités par Cambridge Analytica, leurs implications pour nos sociétés démocratiques, et surtout, les moyens dont nous disposons pour nous protéger contre ces nouvelles formes de manipulation massive. Car si la technologie peut être détournée pour influencer nos comportements, elle peut aussi nous aider à renforcer notre esprit critique et notre autonomie.

Les mécanismes de la manipulation : comprendre la méthode Cambridge Analytica

Le modèle OCEAN : la cartographie de nos personnalités

Au cœur de la stratégie de Cambridge Analytica se trouvait l’utilisation du modèle psychologique des « Big Five » (ou modèle OCEAN), une théorie scientifiquement validée qui décompose la personnalité humaine en cinq traits fondamentaux :

- Ouverture à l’expérience (curiosité, créativité).

- Conscienciosité (organisation, fiabilité).

- Extraversion (sociabilité, énergie).

- Agréabilité (compassion, coopération).

- Névrosisme (anxiété, instabilité émotionnelle).

Ce modèle n’a rien de controversé en soi – il est largement utilisé en psychologie académique depuis les années 1980. Ce qui était inédit, c’était son application systématique et massive à des fins de manipulation politique.

Comment Cambridge Analytica a-t-elle procédé ? Tout a commencé par la collecte de données. En 2014, un chercheur de l’Université de Cambridge, Aleksandr Kogan, a développé une application baptisée « thisisyourdigitallife » proposant un test de personnalité rémunéré (1 à 2 dollars). Pour participer, les utilisateurs devaient accepter de donner accès à leurs données Facebook – mais aussi, et c’est là que réside le problème, à celles de leurs amis, qui n’avaient jamais consenti à un tel partage.

Nous avons ainsi assisté à un phénomène d’expansion exponentielle : environ 270 000 personnes ont effectué le test, mais les données de plus de 87 millions d’utilisateurs ont finalement été collectées. Ces informations ont ensuite été analysées pour créer des profils psychologiques détaillés, permettant de classer les électeurs selon leurs traits de personnalité dominants.

« Sans Cambridge Analytica, il n’y aurait pas eu de Brexit » – Christopher Wylie, ancien employé et lanceur d’alerte

Le microciblage comportemental : des messages personnalisés pour chaque profil

Une fois ces profils établis, Cambridge Analytica a pu mettre en œuvre sa stratégie de « microciblage comportemental » (behavioral microtargeting). Cette technique consiste à adapter précisément les messages politiques en fonction des traits de personnalité identifiés chez chaque électeur.

Par exemple, pour promouvoir une même politique sur le port d’armes, des messages radicalement différents étaient présentés selon les profils :

- Pour les personnes présentant un score élevé en névrosisme (tendance à l’anxiété) : des publicités mettant l’accent sur les menaces extérieures et le besoin de protection.

- Pour celles avec un fort score en conscienciosité : des arguments basés sur la tradition et l’héritage familial.

- Pour les personnes ouvertes à l’expérience : des messages axés sur la liberté individuelle.

Cette personnalisation extrême des messages politiques a permis d’optimiser leur impact persuasif, en résonnant directement avec les craintes, les désirs et les valeurs de chaque électeur. Le problème fondamental est que ces citoyens ignoraient être la cible de messages spécifiquement conçus pour exploiter leurs vulnérabilités psychologiques.

Comme l’explique Paul-Olivier Dehaye, mathématicien ayant contribué à révéler l’affaire : « Cette ignorance des techniques employées transforme des messages de persuasion en manipulation. »

L’exploitation des biais cognitifs à grande échelle

Au-delà du simple ciblage publicitaire, Cambridge Analytica a exploité systématiquement les biais cognitifs bien connus en psychologie sociale :

- Biais de confirmation : en proposant des contenus qui renforcent les croyances préexistantes.

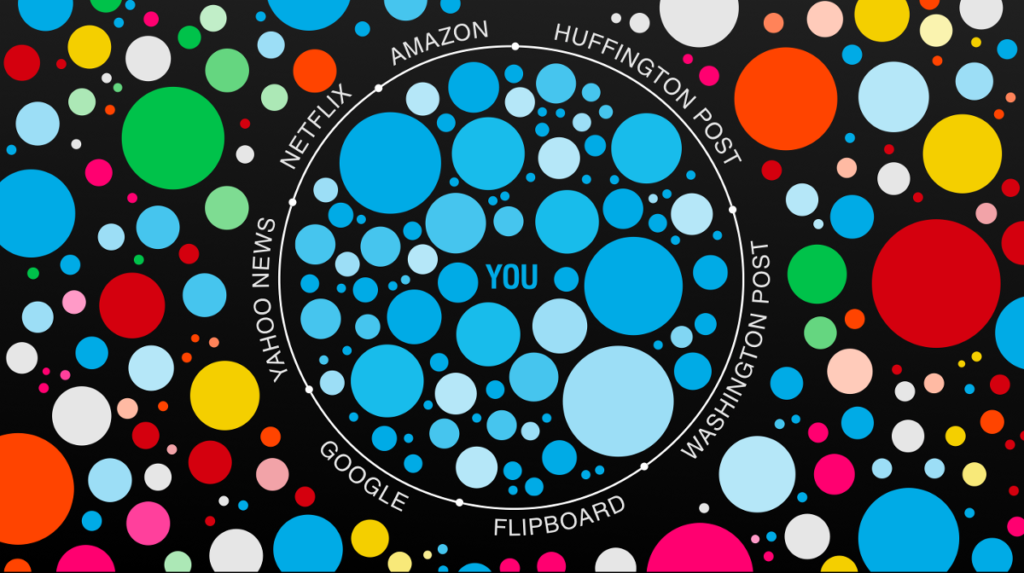

- Effet de chambre d’écho : en isolant les utilisateurs dans des bulles informationnelles.

- Amorçage émotionnel : en utilisant des stimuli émotionnels pour influencer les jugements ultérieurs.

L’efficacité de ces techniques reste débattue. Certains experts, comme Fenwick Mckelvey de l’Université Concordia, estiment que Cambridge Analytica a surtout démontré « le manque de surveillance de cette industrie » plutôt qu’une réelle capacité à manipuler les électeurs. D’autres, comme Michal Kosinski, chercheur à Stanford qui a pionnier certaines de ces techniques, affirment que « ce type de ciblage psychologique est non seulement possible mais efficace comme outil de persuasion de masse. »

Cas d’étude : l’élection présidentielle américaine de 2016

L’élection de Donald Trump en 2016 représente probablement le cas d’étude le plus significatif de l’utilisation des techniques de manipulation psychologique à grande échelle. Cambridge Analytica a été engagée par l’équipe de campagne de Trump pour un montant estimé à 6 millions de dollars.

La stratégie déployée s’est concentrée sur l’identification des « électeurs persuadables » dans les États-clés comme le Michigan, le Wisconsin et la Pennsylvanie – des États remportés avec des marges extrêmement faibles qui ont finalement fait basculer l’élection.

Alexander Nix, alors PDG de Cambridge Analytica, s’est vanté dans une vidéo tournée à son insu : « Nous avons tout ciblé. Nous avons dirigé toute la campagne digitale et nos données alimentaient leur stratégie. » Si l’ampleur exacte de l’influence de ces techniques reste difficile à mesurer avec précision, l’extrême étroitesse des résultats dans certains États-clés (moins de 80 000 voix au total ont fait la différence) suggère qu’une manipulation même limitée a pu jouer un rôle décisif.

Ce qui est particulièrement préoccupant, c’est la nature asymétrique de cette guerre de l’information. Comme l’a souligné Christopher Wylie : « C’était une expérimentation immorale. Vous jouez avec la psychologie d’un pays entier, sans leur consentement ni conscience, en plein processus démocratique […] C’est un service de propagande.«

Les implications éthiques et sociales : au-delà du scandale

L’ébranlement de la démocratie délibérative

L’affaire Cambridge Analytica soulève des questions fondamentales sur la nature même de nos démocraties. La démocratie délibérative repose sur l’idée que les citoyens peuvent former des opinions politiques éclairées à travers un processus de délibération rationnelle et de débat public. Or, les techniques de manipulation psychologique court-circuitent ce processus en s’adressant directement aux émotions et aux biais cognitifs des individus.

Nous assistons à une transformation profonde du discours politique, qui passe d’un espace de délibération collective à une forme de communication publicitaire hyper-personnalisée. Ce phénomène a été qualifié par certains chercheurs de passage d’une « démocratie » à une « datacratie » – un système où les données, et non plus les idées, deviennent le moteur principal du processus politique.

Quand un message politique est tellement personnalisé qu’il devient invisible pour les autres citoyens, comment maintenir un espace public de débat ? Cette fragmentation extrême de l’espace informationnel représente peut-être la menace la plus insidieuse pour nos démocraties.

La surveillance capitaliste et ses conséquences

L’affaire Cambridge Analytica s’inscrit dans un contexte plus large que Shoshana Zuboff, professeure émérite à Harvard, a nommé le « capitalisme de surveillance ». Ce système économique repose sur l’extraction massive de données personnelles qui sont ensuite transformées en « produits prédictifs » permettant d’anticiper et d’influencer les comportements.

Comme l’explique un article de recherche paru dans la revue Cultures & Conflits : « Les données sont devenues une nouvelle ‘marchandise fictive’ qui s’ajoute au travail, à la terre et à la monnaie […] Le capital de plateforme ne devient capital que lorsqu’il est combiné à cette nouvelle marchandise fictive qui agit comme sa ‘matière première’ principale. »

Dans ce contexte, la surveillance et les atteintes continues à la vie privée ne sont pas des accidents ou des excès, mais des éléments intrinsèques au fonctionnement de l’économie numérique. Cambridge Analytica n’a fait qu’exploiter – de manière particulièrement agressive – un système déjà problématique dans ses fondements.

La dimension géopolitique : une menace pour la souveraineté numérique

La manipulation psychologique massive pose également des questions de souveraineté nationale. Les révélations ultérieures ont montré que Cambridge Analytica avait été active dans plus de 60 pays à travers le monde, y compris lors d’élections en Afrique et en Amérique latine.

Dans de nombreux cas, ces campagnes d’influence ont été menées sans aucune considération pour la souveraineté des pays concernés. Ce phénomène représente une forme d’ingérence étrangère d’un nouveau type, plus subtile mais potentiellement plus efficace que les méthodes traditionnelles.

Pour les pays francophones, cette question est particulièrement sensible. La France, la Belgique, la Suisse et le Québec ont tous développé des approches distinctes de la souveraineté numérique, souvent en tension avec le modèle anglo-saxon dominant. L’affaire Cambridge Analytica a renforcé la prise de conscience de la nécessité d’une régulation plus stricte et d’une approche souveraine des questions numériques.

Protections légales et réglementaires : l’approche européenne

Le RGPD : une réponse anticipée

L’une des réponses les plus significatives aux problèmes soulevés par l’affaire Cambridge Analytica est venue d’Europe avec le Règlement Général sur la Protection des Données (RGPD), entré en vigueur en mai 2018, soit juste après l’éclatement du scandale.

Le RGPD a introduit plusieurs principes fondamentaux qui auraient pu prévenir les abus de Cambridge Analytica :

- Le consentement explicite pour la collecte et le traitement des données.

- Le droit à l’information sur l’utilisation des données personnelles.

- Le droit à l’oubli permettant de faire effacer ses données.

- Des sanctions dissuasives pouvant atteindre 4% du chiffre d’affaires mondial.

L’approche européenne se distingue nettement de l’autorégulation américaine en plaçant la protection des données au rang de droit fondamental. Comme l’a noté la Commission européenne suite au scandale : « Afin de contrer d’éventuelles tentatives de manipulation de l’opinion lors des élections européennes, nous menacerons d’imposer des sanctions financières (jusqu’à 5% de leur budget annuel) aux partis politiques qui ne respecteraient pas le RGPD.«

Le Digital Services Act et le Digital Markets Act

L’Union Européenne a poursuivi son effort réglementaire avec l’adoption du Digital Services Act (DSA) et du Digital Markets Act (DMA) en 2022, largement influencés par les leçons tirées de l’affaire Cambridge Analytica.

Ces législations visent notamment à :

- Imposer une transparence accrue sur les algorithmes de ciblage.

- Limiter l’utilisation du microciblage politique.

- Renforcer la responsabilité des plateformes face aux contenus problématiques.

Ces initiatives européennes ont créé un précédent mondial et inspirent désormais des législations similaires dans d’autres régions, y compris au Canada et dans certains pays d’Afrique francophone.

Les limites de l’approche réglementaire

Malgré ces avancées significatives, l’approche réglementaire présente certaines limites :

- Le décalage temporel entre l’évolution technologique et l’adaptation juridique.

- Les difficultés d’application face à des entreprises transnationales.

- Le manque de moyens des autorités de régulation face à des géants technologiques.

Comme le souligne Michael Veale, maître de conférences à l’University College de Londres : « Dans de nombreux cas et quand les lois de l’UE s’appliquent, les données au sujet de l’état mental, un aspect de la santé, sont de ‘catégorie particulière’ selon le RGPD. Leur traitement requiert un consentement explicite. » Toutefois, la mise en œuvre effective de ces principes reste un défi majeur.

Comment se protéger : vers une hygiène numérique citoyenne

Reconnaître les signes de manipulation psychologique

Tableau : Signaux d’alerte de manipulation psychologique en ligne

| Signal d’alerte | Description | Action recommandée |

| Contenu émotionnellement chargé | Messages jouant sur la peur, la colère ou l’indignation | Prendre du recul et analyser rationnellement l’information |

| Offres « trop personnalisées » | Contenu qui semble connaître vos préoccupations intimes | Vérifier les paramètres de confidentialité de vos comptes |

| Urgence artificielle | Messages poussant à agir immédiatement sans réflexion | Se donner un temps de réflexion obligatoire |

| Sources opaques | Informations dont l’origine est difficile à vérifier | Rechercher des sources multiples et fiables |

| Polarisation extrême | Contenu présentant le monde de façon binaire | Rechercher des points de vue nuancés |

La première étape pour se protéger consiste à développer une conscience accrue des techniques de manipulation. Les recherches en psychologie cognitive montrent que la simple connaissance des biais cognitifs réduit significativement leur impact. C’est ce qu’on appelle l’effet de « méta-cognition » – penser sur notre façon de penser.

Il est particulièrement important d’être attentif aux contenus qui suscitent des réactions émotionnelles fortes. Comme l’explique Alexandre Coutant, chercheur à l’UQAM : « Ces techniques se fondent sur l’idée qu’un seul critère serait déterminant dans le choix des gens, mais en réalité c’est rarement le cas. Les facteurs émotifs sont difficiles à cerner.«

Renforcer sa souveraineté numérique personnelle

Au-delà de la vigilance, plusieurs mesures concrètes peuvent être adoptées pour renforcer notre souveraineté numérique personnelle :

- Auditer régulièrement ses paramètres de confidentialité sur les réseaux sociaux.

- Utiliser des outils de protection de la vie privée (VPN, navigateurs axés sur la confidentialité).

- Diversifier ses sources d’information pour sortir des bulles de filtrage.

- Limiter volontairement le temps passé sur les réseaux sociaux pour réduire l’exposition.

- Pratiquer la « déconnexion sélective » en définissant des périodes sans écrans.

Il est également essentiel de comprendre que notre vie numérique est un espace politique. Chaque clic, chaque partage, chaque « j’aime » s’inscrit dans une économie de l’attention qui peut être détournée à des fins de manipulation. Reprendre le contrôle de notre attention est donc un acte politique en soi.

L’éducation aux médias : un rempart collectif

L’affaire Cambridge Analytica a démontré que les solutions purement individuelles sont insuffisantes face à des systèmes d’influence aussi sophistiqués. Une approche collective, centrée sur l’éducation aux médias et à l’information (EMI), est indispensable.

Les programmes d’EMI visent à développer :

- La pensée critique face aux contenus médiatiques.

- La compréhension technique des systèmes numériques.

- La conscience éthique des enjeux liés aux données personnelles.

Ces compétences doivent être intégrées dans les programmes scolaires dès le plus jeune âge, mais aussi faire l’objet de formations continues pour les adultes. Comme le suggère un rapport du Parlement européen : « Face aux menaces que représentent la désinformation et la manipulation psychologique, l’éducation aux médias constitue notre meilleure ligne de défense à long terme.«

Le futur de la manipulation psychologique : tendances et perspectives

L’intelligence artificielle : amplificateur de manipulation

Les techniques utilisées par Cambridge Analytica sembleront bientôt rudimentaires en comparaison de ce que permettent les avancées en intelligence artificielle. Les systèmes d’IA générative peuvent désormais :

- Créer des contenus personnalisés à grande échelle.

- Simuler des interactions humaines convaincantes.

- Analyser et exploiter des modèles comportementaux complexes.

L’IA conversationnelle, en particulier, ouvre la voie à des formes de manipulation encore plus subtiles et efficaces. Imaginez un agent conversationnel capable d’adapter en temps réel son discours en fonction de vos réactions émotionnelles détectées via votre webcam ou votre microphone.

La réalité augmentée et virtuelle : nouveaux terrains de manipulation

L’émergence des technologies de réalité augmentée et virtuelle crée de nouveaux espaces potentiels pour la manipulation psychologique. Ces environnements immersifs offrent un contrôle sans précédent sur l’expérience perceptive des utilisateurs.

Les recherches en psychologie montrent que les expériences vécues en réalité virtuelle peuvent avoir un impact psychologique comparable aux expériences réelles, tout en permettant une manipulation totale du contexte. Cette combinaison crée des possibilités inédites d’influence comportementale.

Vers une éthique de l’influence numérique ?

Face à ces défis, nous assistons à l’émergence d’initiatives visant à définir une éthique de l’influence numérique. Des chercheurs, des entreprises et des organisations de la société civile travaillent à l’élaboration de principes directeurs pour distinguer la persuasion légitime de la manipulation abusive.

Ces efforts s’articulent autour de principes comme :

- La transparence des méthodes d’influence.

- Le consentement éclairé des personnes ciblées.

- La proportionnalité entre les moyens employés et les objectifs poursuivis.

- Le respect de l’autonomie décisionnelle des individus.

Nous nous trouvons à un moment charnière où ces principes éthiques doivent être intégrés dans la conception même des systèmes d’influence numérique – ce qu’on appelle l’éthique « by design ».

Conclusion : reprendre le contrôle de notre avenir numérique

L’affaire Cambridge Analytica a joué un rôle de révélateur, mettant en lumière des pratiques qui existaient depuis longtemps dans l’ombre. Si le scandale a suscité une indignation légitime, il a aussi catalysé une prise de conscience salutaire sur les dangers de la manipulation psychologique massive à l’ère numérique.

Nous avons exploré dans cet article les mécanismes complexes de cette manipulation, ses implications profondes pour nos sociétés démocratiques, et les réponses qui émergent tant au niveau réglementaire qu’individuel. Il apparaît clairement que ni la régulation seule, ni les mesures individuelles isolées ne suffiront à relever ce défi.

Ce qui est en jeu, c’est rien moins que notre autonomie cognitive et notre capacité à maintenir un espace public de délibération démocratique. Face à ces enjeux, nous devons adopter une approche globale qui combine :

- Des régulations strictes protégeant les données personnelles.

- Une éducation critique aux médias et au numérique.

- Des innovations technologiques au service de l’émancipation.

- Une mobilisation citoyenne pour un internet plus éthique.

L’affaire Cambridge Analytica nous a révélé la face sombre du pouvoir des données et de la psychologie appliquée. À nous maintenant de reprendre ces outils pour construire un avenir numérique au service de l’émancipation humaine plutôt que de la manipulation.

Comme nous l’avons vu tout au long de cet article, nous ne sommes pas condamnés à subir passivement ces systèmes d’influence. En développant notre compréhension des mécanismes de manipulation, en exigeant des technologies plus éthiques, et en cultivant notre esprit critique, nous pouvons transformer cette crise en opportunité pour repenser fondamentalement notre relation au numérique.

Et vous, quelles mesures prenez-vous pour protéger votre souveraineté cognitive dans l’environnement numérique ? Partagez vos pratiques et réflexions dans les commentaires ci-dessous.

FAQ : Questions fréquentes sur Cambridge Analytica

Q1 : Les techniques de Cambridge Analytica ont-elles réellement influencé les résultats électoraux ?

R : Il est difficile d’établir avec certitude l’impact exact des techniques de microciblage sur les résultats électoraux. Cependant, dans des scrutins serrés comme l’élection présidentielle américaine de 2016 ou le référendum sur le Brexit, même une influence marginale sur quelques milliers d’électeurs a pu être décisive. Des études scientifiques récentes tendent à confirmer l’efficacité du ciblage psychologique dans la modification des comportements.

Q2 : Comment savoir si je fais partie des utilisateurs dont les données ont été exploitées par Cambridge Analytica ?

R : Facebook a mis en place une page permettant de vérifier si vos données ont été partagées avec Cambridge Analytica. Cependant, au-delà de ce cas spécifique, il est prudent de considérer que vos données ont pu être exploitées par d’autres acteurs utilisant des méthodes similaires, étant donné la prévalence de ces pratiques.

Q3 : Les réglementations comme le RGPD sont-elles suffisantes pour empêcher de futurs scandales similaires ?

R : Le RGPD constitue une avancée significative, mais présente des limites. Son efficacité dépend largement des moyens alloués aux autorités de régulation et de la volonté politique de l’appliquer strictement. De plus, les innovations technologiques créent constamment de nouveaux défis que la réglementation doit s’efforcer de suivre. Une approche combinant régulation, éducation et solutions techniques reste nécessaire.

Références bibliographiques

Cardon, D. (2018). Le scandale Cambridge Analytica contextualisé : le capital de plateforme et le RGPD. Cultures & Conflits, 109, 39-60. https://journals.openedition.org/conflits/19779

Kosinski, M., Stillwell, D., & Graepel, T. (2013). Private traits and attributes are predictable from digital records of human behavior. Proceedings of the National Academy of Sciences, 110(15), 5802-5805. https://www.pnas.org/content/110/15/5802

Matz, S. C., Kosinski, M., Nave, G., & Stillwell, D. J. (2017). Psychological targeting as an effective approach to digital mass persuasion. Proceedings of the National Academy of Sciences, 114(48), 12714-12719. https://www.pnas.org/content/114/48/12714

Wylie, C. (2019). Mindfck: Cambridge Analytica and the Plot to Break America*. Random House.

Zuboff, S. (2019). The Age of Surveillance Capitalism: The Fight for a Human Future at the New Frontier of Power. Public Affairs.

Information Commissioner’s Office. (2018). Investigation into the use of data analytics in political campaigns. ICO. https://ico.org.uk/media/action-weve-taken/2260271/investigation-into-the-use-of-data-analytics-in-political-campaigns-final-20181105.pdf

Commission européenne. (2018). Code de bonnes pratiques contre la désinformation. https://digital-strategy.ec.europa.eu/fr/policies/code-practice-disinformation

Bailey, M. A., Hopkins, D. J., & Rogers, T. (2016). Unresponsive and Unpersuaded: The Unintended Consequences of a Voter Persuasion Effort. Political Behavior, 38(3), 713-746. https://link.springer.com/article/10.1007/s11109-016-9338-8